GAIQ日本語でテスト受けることができるようになりましたー。

少しずつ勉強します。メモします。

回答は自分で考えたものをメモしているだけなので、正解ではありません。

間違っているかもしれません。

その場合はぜひ教えてください。

Q:Google アナリティクス 4 プロパティをユニバーサル アナリティクス プロパティと区別するものはどのようなことですか。

Google アナリティクス 4 プロパティではデータの収集とレポートの基盤に「イベント」を使うが、ユニバーサル アナリティクスではデータの収集とレポートの基盤に「ディメンション」を使う。

2 Google アナリティクス 4 プロパティはデータの収集とレポートの基盤に「ディメンション」を使うが、ユニバーサル アナリティクスではデータの収集とレポートの基盤に「イベント」を使う。

3 Google アナリティクス 4 プロパティではデータの収集とレポートの基盤に「イベント」を使うが、ユニバーサル アナリティクスではデータの収集とレポートの基盤に「セッション」を使う。

4 Google アナリティクス 4 プロパティはデータの収集とレポートの基盤に「セッション」を使うが、ユニバーサル アナリティクスではデータの収集とレポートの基盤に「イベント」を使う。

回答:3

Q:あなたは、顧客のエンゲージメントについての詳細なインサイト を確認できる、標準的なレポートのレベルを超える高度な手法を見つけたいと思っています。

Google アナリティクスのプロパティのセクションのうち、その情報があるのはどこですか。

探す

広告

レポート

A:レポートのことかなー???グラフっぽいマークのことだよね。?

インサイト

Q:あなたはハードウェア店の経営者で、自社が販売するツールの正しい使い方を顧客が学べる新しいハウツー動画を、自社のウェブサイトに投稿します。Google アナリティクスには、この動画へのユーザーの反応に関するデータが多数入っています。

Google アナリティクスによって収集されたと思われる「ユーザー プロパティ」は、次のうちどれですか。

2 サイトで動画を見ているユーザーの言語設定

3 サイトで動画を見たユーザーの人数

4 サイトでユーザーが見られる動画の名前

回答:2 サイトで動画を見ているユーザーの言語設定は、Google アナリティクスによって収集された可能性があります

しかし、1、3、4は、Google アナリティクスによって収集されたユーザープロパティではありません。Google アナリティクスが収集するユーザープロパティには、デバイス 、ブラウザ、地理的位置、言語などが含まれます。

Q あなたは小さな会社を経営していて、会社にはウェブサイトの他に、iOS 用アプリと Android 用アプリがあります。これら 3 つを総合的に見てイベントとユーザーを分析することが目的の場合、アカウントをどのように設定すべきですか。

1 ウェブサイト用のウェブデータ ストリームを含む 1 つのプロパティと、アプリ用のアプリデータ ストリームを含む 1 つのプロパティ

2 ウェブサイト用のウェブデータ ストリーム 1 つとアプリ用のアプリデータ ストリーム 1 つを含む 1 つのプロパティ

3 ウェブサイト用のウェブデータ ストリーム 1 つを含む 1 つのプロパティと、2 つのアプリデータ ストリーム(iOS 用 1 つと Android 用 1 つ)を含む 1 つのプロパティ

4 ウェブサイト用のウェブデータ ストリーム 1 つと アプリデータ ストリーム 2 つ(iOS 用 1 つと Android 用 1 つ)を含む 1 つのプロパティ

A:4 WEB,IOS アプリ、Android アプリ、すべてひとつのプロパティでよいと思うのですが。

Q オーディエンス トリガーを使用すると何ができるようになりますか。

2 トリガーされている特定のイベントに基づいて新しいイベントを作成する

3 既存のイベントのパラメータに基づいて新しいイベントを作成する

4 達成されているオーディエンスのルールに基づいて新しいイベントを作成する

回答 4 達成されているオーディエンスのルールに基づいて新しいイベントを作成することができます。

オーディエンストリガーを使用すると、特定のオーディエンスがサイト上で特定の行動を実行した場合に、そのオーディエンスに関する新しいイベントをトリガーできます。たとえば、特定のページを訪問したユーザーに対してメールキャンペーンを開始することができます。オーディエンストリガーは、Google タグマネージャーで設定できます。

Q あなたは、Google アナリティクス プロパティの [探索] セクションを表示しています。指標とディメンションを表形式にカスタマイズするには、次の探索手法のうちどれを使用すべきですか。

1 目標到達プロセスデータ探索

2 自由形 式

3 コホート データ探索

4 セグメントの重複

A:2かなー。

Q あなたは、数人の寄稿者を擁するブログを管理する編集者です。

各記事のページに投稿者の名前を報告するには、どれを使えばよいですか。

1カスタム表

2 カスタム ディメンション

3 カスタム ユーザー パラメータ

A 2 カスタムディメンションかな。というかほかの二つ何?

Q あなたがビジネス オーナーで、ユーザーがどのようにして自社のウェブサイトとアプリに到達しているかや両プラットフォームでのユーザーの行動を知りたい場合、何を使用すればインサイト を生成できますか。

1 Google マーケティング プラットフォーム

2 ユニバーサル アナリティクス プロパティ

3 Google アナリティクス 4 プロパティ

4 Google オプティマ イズ

A:3 Google アナリティクス 4 プロパティ

Q あなたは、新規ユーザーが自社のホームページを見た後にどのページを最も頻繁に開いているかを知りたいと思っています。そのため、新しい経路データ探索機能を [探索] 内に作成し、そのデータを同僚と共有します。

この新しい経路データ探索のデータを見られるのは、デフォルトでは誰になりますか。

1 データを見られるのは自分だけだが、プロパティの他のユーザーと編集可能な状態で共有することは可能。

2 データを見られるのは自分だけだが、プロパティの他のユーザーと読み取り専用モードで共有することは可能。

3 プロパティ内の誰でも、アクセスして編集することが可能。

4 プロパティ内の誰でも、読み取り専用モードでアクセス可能。

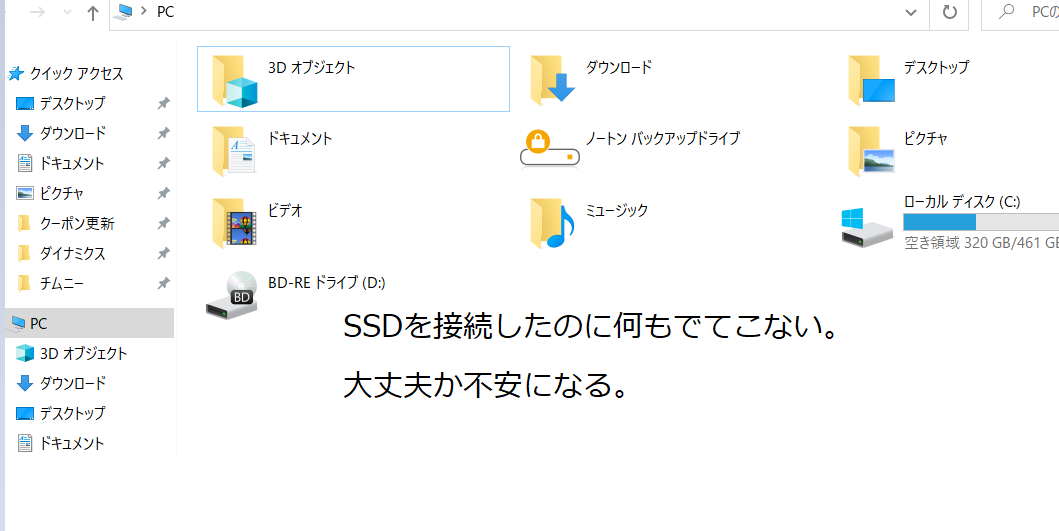

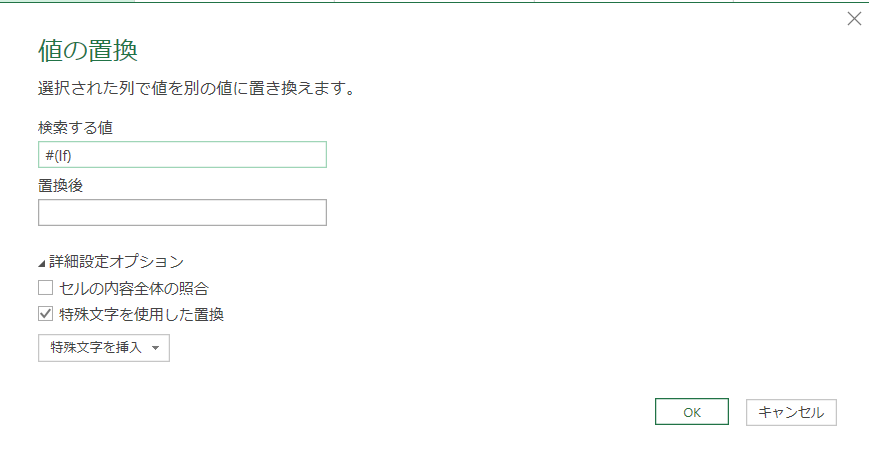

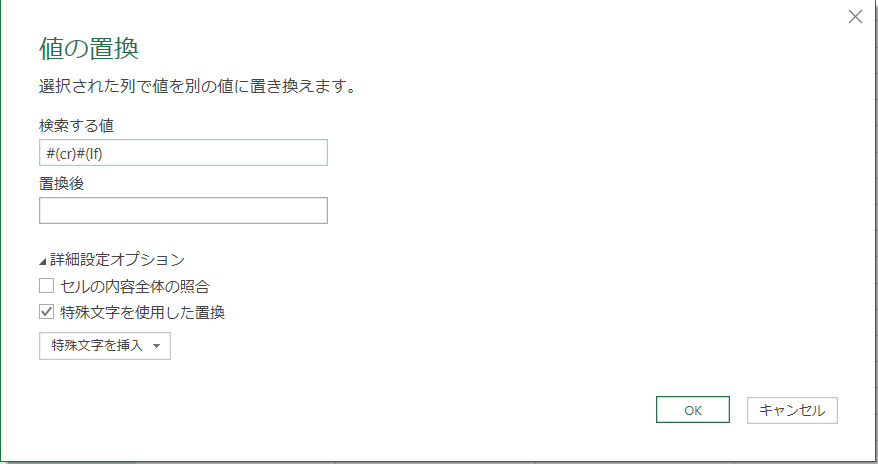

A: 2番 デフォルトでは誰ですかとあるので実際にためしてみた。↓

Q 次の探索手法のうちどれを使えば、ユーザーが重要なタスクやコンバージョンに至るまでのステップを可視化して、各ステップでどの程度タスクやコンバージョンに成功しているか、または失敗しているかを確認できますか。

1 目標到達プロセスデータ探索

2 自由形 式

3 セグメントの重複

4 コホート データ探索

A:1 目標到達プロセスデータ探索

Q あるウェブサイトの管理者であるあなたは、一部のイベント(ユーザーがニュースレターに登録したとか商品を購入したとか)を非常に有益だと考えています。

そのようなイベントを重要であると指定して価値を割り当てたい場合、Google アナリティクス 4 プロパティではそのイベントにどのようにラベル付けするべきでしょうか。

1 スタム イベント

2 目標

3 コンバージョン イベント

4 推奨イベント

A 3 コンバージョンイベント

「コンバージョンイベント」は、ユーザーが特定のアクションを完了したことを示すものです。例えば、ニュースレターに登録したり、商品を購入したりするなど、管理者が有益だと考えているイベントを特定することができます。このようなイベントを「コンバージョンイベント」として設定することで、重要なイベントに対して価値を割り当てることができます。

Q:自社のウェブサイトへユーザーを呼んでいるオーガニック検索クエリのインサイト を獲得するために、アナリティクスを結びつけるとよいプラットフォームはどれですか 。

1 Google 広告

2 Google オプティマ イズ

3 検索広告 360

4 サーチコンソール

回答4

サーチコンソールは、Google が提供する無料のツールで、ウェブサイトの検索エンジン 上での表示状況や検索クエリの情報を提供します。ウェブサイトの統計情報を収集し、SEO 改善に役立てることができます。オーガニック検索クエリのインサイト を獲得するためには、サーチコンソールを結びつけることが適しています。

Q:あなたは、過去 30 日間にユーザーがアクセスに使用したデバイス のタイプ(パソコンやスマートフォン など)を示すレポートを作成します。

このレポートでは、デバイス のタイプは何ですか。

2 指標

3 イベント

4 ディメンション

回答 4 ディメンションGoogle アナリティクスにおいて、集計されるデータを説明する属性のことであり、レポートの中でデータを分類するために使用されます。デバイス のタイプは、ディメンションの一つであり、過去30日間にユーザーがアクセスに使用したデバイス のタイプを示すレポートを作成する場合には、デバイス タイプをディメンションとして選択する必要があります。

Q:あなたは、自社のウェブサイトとアプリから Google アナリティクスへ送信するデータの補完になりそうな POS システムのデータを収集しています。

次のどの機能を使用すれば、イベントを収集して Google アナリティクス サーバーへ直接送信できますか。

2 HTTP リクエス ト

3 データ インポート

4 測定プロトコル

回答:

4 測定プロトコル Google Analytics は、測定プロトコル (Measurement Protocol)を提供しており、これを使用することで、Google Analytics にデータを直接送信することができます。測定プロトコル を使用することで、POSシステムのデータをGoogle Analytics に統合し、ウェブサイトやアプリのデータと組み合わせて、ビジネスの洞察を得ることができます。

Q:自社のウェブサイトに Google アナリティクスを活用している場合に [エンゲージメント] の概要レポートが便利なのは、次のどのシナリオですか。

2 ユーザーがどこから自社のウェブサイトにたどり着いているかを見たいとき。

3 オンラインでの閲覧および購入のアクティビティを通じてユーザーが表している興味の対象に関するインサイト が欲しいとき。

4 自社のサイトのどのページが最も多くのトラフィック を獲得しているかを見たいとき。

回答:3オンラインでの閲覧および購入のアクティビティを通じてユーザーが表している興味の対象に関するインサイト が欲しいとき。

インサイト を得ることができます。

Q:モバイルアプリからデータを収集して Google アナリティクス 4 プロパティに送信するためには、次のツールのうちどれを使用すればよいですか。

1 Firebase SDK

2 Google 広告

3 Google マーケティング プラットフォーム

4 ウェブサイト タグ

回答:1 Firebase SDK

Q あなたは自社のウェブサイトとモバイルアプリ用に Google アナリティクス 4 プロパティを作成しました。ユーザーがウェブサイトとアプリにエンゲージすると、Google アナリティクスではどのように個別のユーザーの操作を測定して報告しますか。

2 ヒットとして

3 セッションとして

4 イベントとして

回答:4 イベントとして

Q:あなたは、Google アナリティクスのデータを BigQuery にエクスポートしてクエリを実行し、オフライン データの一部をアナリティクスのデータと結合したいと思っています。

BigQuery にエクスポート可能なアナリティクスのプロパティのタイプは次のうちどれですか。

2 GA4 を使用する標準プロパティまたはアナリティクス 360 プロパティ

3 GA4 またはユニバーサル アナリティクスの標準プロパティのみ

4 GA4 またはユニバーサル アナリティクスのアナリティクス 360 プロパティのみ

回答:2 GA4 を使用する標準プロパティまたはアナリティクス 360 プロパティ

Q:「コンバージョン経路」では、コンバージョン経路において各種の広告がどのように作用し合うかを見ることができます。「コンバージョン経路」のレポートは、Google アナリティクス 4 プロパティのどこで見られるでしょうか。

2 広告

3 レポート

4 設定

回答: 3「コンバージョン経路」のレポートは、Google アナリティクス 4 プロパティの「レポート」セクションで見ることができます。

あれー

広告の箇所にコンバージョン経路あるよー

Q:あなたは、自社のウェブサイトが Google アナリティクス プロパティにデータをフィードするようなウェブデータ ストリームを設定中です。ウェブデータ ストリームの設定中、拡張計測機能の設定を有効のままにしておくと、どのようなことが起こりますか。

2 自分でウェブサイトのコードを変更しなくても、ウェブサイトから追加のイベントが収集される

3 ウェブデータ ストリームのコンバージョン レポートが機械学習 を利用してクレジットを各チャネルに配分する

4 ログインしているユーザーにイベントを関連付けて、クロスデバイス レポートを有効にできる

回答:2

Q:Google アナリティクス アカウントからあるプロパティを削除した場合、そのプロパティが完全に削除されるまでに何日間の猶予がありますか。

2 35

3 60

4 7

回答 2 35日

Google アナリティクス アカウントからプロパティを削除した場合、そのプロパティが完全に削除されるまでに35日間の猶予があります。この35日間は、削除されたプロパティに関連するデータを復元するために必要な期間です。